Das Projekt „Conversational AI for Digital Twin“ ermöglicht es Nutzern, durch einen digitalen Assistenten nahtlos mit den Daten Ihres Unternehmens zu kommunizieren und datengesteuerte Entscheidungen zu treffen.

Projektziele

Das Projekt zielt darauf ab, mithilfe des Services „Kognitive große Sprachmodelle für konversationelle KI-Assistenten“ (Fraunhofer IAIS), einen digitalen Assistenten zu entwickeln. Dieser Assistent soll es Benutzern vereinfachen, nahtlos mit den Daten innerhalb ihres Unternehmens zu kommunizieren, um eine mühelose datengesteuerte Entscheidungsfindung mit optimierter Ressourcennutzung zu ermöglichen. Durch den Assistenten können die Mitarbeiter also mit einem digitalen Zwilling des Unternehmens, repräsentiert durch einen Wissensgraphen (Daten), sprechen, indem sie die Leistungsfähigkeit von Large Language Models (LLMs) nutzen.

Welchen Problemen begegnet das Projekt? Eine Schwierigkeit ist für die Nutzer, dass jeder Wissensgraph von einer Ontologie oder einem Schema repräsentiert wird und es Fachwissen erfordert, um entsprechende Einblicke zu gewinnen und Daten zielgerichtet abzufragen. Zudem werden die Abfrageergebnisse im RDF-Format (Resource Description Framework) dargestellt, wodurch eine sprachliche Barriere entsteht.

Wir streben daher folgende Verbesserungen an:

- Müheloses Lesen von Ontologie-Schemata: Unser digitaler Assistent liest nahtlos das Schema jeder Ontologie, um eine gute Datenanalyse zu gewährleisten.

- Dynamische Abfragegenerierung: Das LLM generiert Abfragen, die der Ontologie entsprechen.

- Sofortige Abfrageausführung: Die Anwendung führt generierte Abfragen schnell aus und liefert Hinweise und Ergebnisse.

- Benutzerfreundliche Ergebnisse: Die Rohabfrageergebnisse werden in leicht verständliche Natursprache umgewandelt.

Projektergebnisse

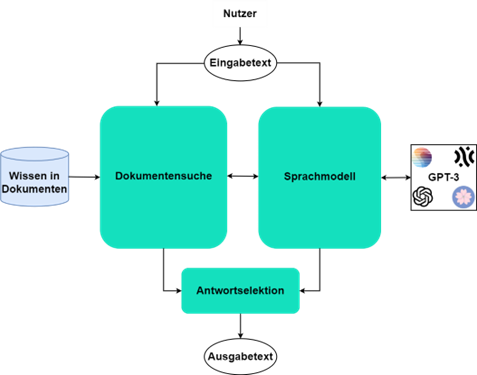

Wir haben eine Pipeline für das Projekt aufgebaut, in der der Benutzer eine Frage zu seinen Unternehmensdaten stellt, die an das LLM weitergeleitet wird. Wir laden die Ontologie des Wissensgraphen in das LLM hoch und bitten das Modell, die Benutzerfrage in natürlicher Sprache, in eine SPARQL-Abfrage entsprechend der Ontologie zu übersetzen. Die Abfrage wird dann an den Triplestore (Datenbank) gesendet, um die Ergebnisse abzurufen. Da wir mit Digital Twin arbeiten, fließt der gesamte Datenfluss im RDF-Format. Daher senden wir die Ergebnisse erneut an das LLM, um sie bei Bedarf in natürliche Sprache zu übersetzen. Dies ermöglicht es den Benutzern, mit den Daten auf umfassendste Weise zu kommunizieren.

Wir haben LLAMA 2 von Meta als LLM für unsere Anwendung zugrundegelegt. Wir haben uns für die 13B-Version des Modells entschieden und sie bezüglich der Beispielontologie angepasst, um die Leistung zu verbessern. Die 7B-Version des Modells funktioniert zum einen nicht gut bei der Erstellung von SPARQL-Abfragen, und zum anderen erfordert die 70B-Version des Modells sehr hohe GPU-Leistung.

Eines der am meisten erwarteten Triplestores für RDF-Daten ist Fuseki. Es ist jedoch langsam, wenn der Wissensgraph groß ist. Daher haben wir Apache Jena TDB als Datenbank für unsere Anwendung angepasst, da sie skalierbarer und persistenter ist.

Kurz gesagt haben wir eine Konversations-KI für den digitalen Zwilling mit einer feingetunten 13B-Version von LLAMA 2 erstellt, die die Balance zwischen GPU-Leistung und Performance hält, mit einem skalierbaren Triplestore für RDF-Daten.

Dieser Assistent wird Mitarbeitenden in der Industrie helfen, ihre datengesteuerte Entscheidungsfindung zu verbessern und durch die Durchführung in natürlicher Sprache dabei noch viel schneller zu werden.

Nächste Schritte

Unser nächster Schritt für das Projekt ist es, die Anwendung mit mehr industriellen Daten zu testen. Wir möchten den Feinabstimmungsprozess verbessern, um die Halluzinationen auf ein Minimum zu reduzieren. Außerdem möchten wir die Visualisierung der Daten einbeziehen, da diese Anwendung derzeit nur die Ergebnisse der Abfragen anzeigt.

Projektzeitraum

01.05.2023 – 31.12.2023

Projektpartner

Fraunhofer IAIS: Dr. Joachim Köhler, Tasneem Tazeen Rashid, Abderrahmane Khiat

ZF Friedrichshafen AG: Nico Wilhelm